万字长文:2020智源大会总结-多角度看AI的未来

导读:智源大会2020 聚焦AI的未来,大家都知道, 2010是深度学习的时代, 我们经历了AI从巅峰进入到瓶颈的过程。那么什么是2020这个十年AI的中心?近一段大家逐步从各个不同的角度切入到这个主题, 比如从相关到因果, 从感知到认知, 重新结合符号主义, 结合脑科学,发展基础数学等, 而2020的智源大会,就是分别从这些不同角度进行跨学科交流的一次盛会。

1 因果角度

1 因果角度

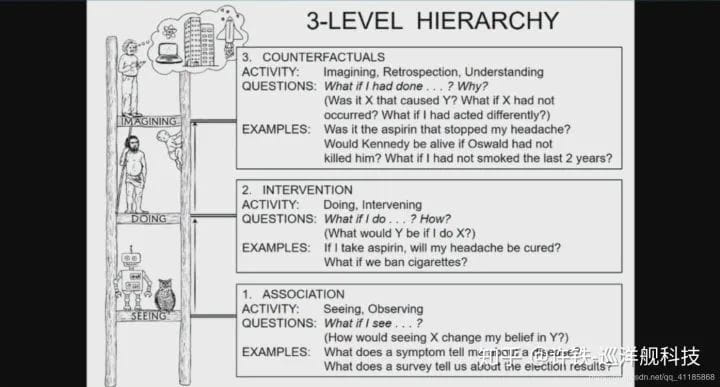

一个当下机器学习界的共识是,机器学习需要从感知过度到认知,但是对于如何引导这次革命,大家的答案是不一样的, 而一个重要的观点在于当下机器没有因果推理的能力。这次会议有幸请到Jude Pearl, 因果被称为是第二次数学科学革命。因为对于我们需要回答的大部分问题 ,都密切依赖我们对因果关系的建模, 这些问题包含对行为结果的分析和反事实推理。比如当下如果我要达到目标A, 我如何构建中间条件, 如果我没有做某事今天会怎样(反事实)等。而这些能力是当下深度学习所不具备的, Jude Pearl的演讲深入浅出的引入了这个问题, 并用几个生动的例子提出了指出一些可能的解决方法。因果理论的核心,就是do calculus, 它提到我们的模型如果要包含因果,就要能够模拟由行为产生的结果的不同, 这和我们之前物理的mechanic model 是相通的。**你有现象模型可以预测数据,但是这是观测数据的联系,而非基于某个行为产生一定变化的因果模型。**为了建立这样的模型,一些必要的数学工具是必不可少的, 比如概率图模型,独立因果分析框架, 有关反事实的数学模型等。 2 认知和脑网络角度

2 认知和脑网络角度

让人工智能具有认知能力那么最直接的解决方法无疑是直接模拟人类的理解和思维能力。2.1 毕彦超 人类的平行知识表示系统我们的知识一种是从经验提取的,一种是存在人脑中的先验知识。对于神经网络,对于同样的事物,比如香蕉和苹果,红色和黄色, 我们既可以形成类似CNN的物体表示, 又可以生成类似语义网络那样的符号结构(知识图谱)。这两种系统的认知基础是什么?毕研超团队通过研究先天盲人和健康人对类似的颜色等概念的表征,证实了平行的知识表示系统的存在。例如盲人和正常人都可以形成对不同颜色的概念表示,但是这些表示通过FMRI 显示背后活跃的脑区是有区别的。而盲人的概念表示更接近语义网络, 正常人却相似CNN经过ImageNet训练得到的一般表示。我们知道大脑最终学习概念需要学习得到从感知到抽象符号的关系, 并通过概念之间的关联来定位一个特定概念。那么是否这两种表示系统需要以某种形式耦合得到人类的知识表示, 这是一个非常值得思考的方向。 事实上我们发现salientcy map 从V1 就有很强的表达 ,说明这种自下而上的注意力是很基础的。而这类attention model 也不同于我们AI的模型,而是一个动态图, 始终在搜索图片最具有信息的地方作为关注点, 然后跳到下一个点。构建一个动态的attnetion model 。2.2 刘嘉 From representation to computation : the cognitve neurointelligence通过AI研究大脑, 通过大脑启发AI, 这个讲座告诉大家如何比较深度神经网络和大脑的”思考“方式, 如果有一天两者开始对话,他们能够互相理解对方吗?刘教授从心理学的角度来讲解如何对比深度神经网络和人脑两个信息处理的黑箱到底能否直接进行对比, 假定我们了解了人脑认知的结构, 那么是否可以用来启发人工智能系统 。我们说当下的深度网络是一个黑箱,事实上心理学也经常把我们的大脑比喻成黑箱。黑箱和黑箱进行比较,似乎是不可能的任务, 然而刘嘉团队的方法 -逆向相关化使这个问题变成可能。这里介绍人脸识别(此处以性别识别为例)的工作,无论对人还是计算机这都是一个很重要的工作。然而我们并不清楚无论是人还是机器是怎么完成这个任务的。这里我们可以想法得到女性和男性的平均脸(无数面孔的平均)。然后在这个平均脸上加上各类人为生成的奇怪噪声然后并让机器(一个训练好的VGG网络)分类是男是女, 这样我们就可以得到一组“男性”噪声 和 “女性” 噪声,我们分别把两组噪声再此分别叠加平均后就得到两个奇怪的斑图,我们可以称为feature 图。然后我们把“男噪声” 和“女噪声”两个相减得到一个差值的feature图, 我们会发现这时候一个非常清晰的图案从噪声里涌现出来,比如我们看到眼角,嘴角,和下巴轮廓等。这就是机器用来分辨人类的特征图,或者说机器识别人脸的因子图。然后团队对人做了相同的分析,也得到人对性别识别的这个因子图, 这时候我们可以分析人和计算机识别人脸的相关性高达0.73 , 说明人和计算机学习到的性格学习方法高度同质化。同时这也说明随机噪声其实是有结构的, 我们对这个特征图做低频和高频的傅里叶分解,可以看到低频部分人和VGG(vgg face)相关性更高。这让机器和人对人脸的表示相关性极高且集中于低频。这里讨论比较认知科学和机器学习的关联的时候,我们最好引入David Marr的三个层次语言体系, 也就是计算层, 表示层,硬件层, 人和VGG模型的计算目标(最高层)是相同的,在硬件层显然大相径庭, 这个研究表明在第二层次表征层两者却是高度相通的。刚刚用到的网络是专门为人脸训练的。我们也可以用迁移学习转移一个从ImageNet训练的通用CNN,然后训练读出层,用迁移学习来识别人脸,这时候两者的表征是否相通呢?实验表明两者表征居然依然是类似的。最后研究团队用sparse coding来认识这件事。sparse coding的原理表明, 随着网络层级的提高,网络表示的稀疏性随层级增加, 这将导致对人脸识别的关键特征会呈现disentagle的离散化形式,也就是可能只有少数神经元编码一个特征(这是神经编码sparse coding和symbolic 表示的内在联系, 最终的表示是一个稀疏因子图) 事实上高层越稀疏, 分类效果越好, 比如alexnet。人脑和深度网络的共同选择。心理学可以用来理解深度学习, 得到一个可解释的神经网络。*** 从这个讲座一个有意思的延申, 似乎我们个人识别美丑的特征正是这些用于性别识别的特征。

事实上我们发现salientcy map 从V1 就有很强的表达 ,说明这种自下而上的注意力是很基础的。而这类attention model 也不同于我们AI的模型,而是一个动态图, 始终在搜索图片最具有信息的地方作为关注点, 然后跳到下一个点。构建一个动态的attnetion model 。2.2 刘嘉 From representation to computation : the cognitve neurointelligence通过AI研究大脑, 通过大脑启发AI, 这个讲座告诉大家如何比较深度神经网络和大脑的”思考“方式, 如果有一天两者开始对话,他们能够互相理解对方吗?刘教授从心理学的角度来讲解如何对比深度神经网络和人脑两个信息处理的黑箱到底能否直接进行对比, 假定我们了解了人脑认知的结构, 那么是否可以用来启发人工智能系统 。我们说当下的深度网络是一个黑箱,事实上心理学也经常把我们的大脑比喻成黑箱。黑箱和黑箱进行比较,似乎是不可能的任务, 然而刘嘉团队的方法 -逆向相关化使这个问题变成可能。这里介绍人脸识别(此处以性别识别为例)的工作,无论对人还是计算机这都是一个很重要的工作。然而我们并不清楚无论是人还是机器是怎么完成这个任务的。这里我们可以想法得到女性和男性的平均脸(无数面孔的平均)。然后在这个平均脸上加上各类人为生成的奇怪噪声然后并让机器(一个训练好的VGG网络)分类是男是女, 这样我们就可以得到一组“男性”噪声 和 “女性” 噪声,我们分别把两组噪声再此分别叠加平均后就得到两个奇怪的斑图,我们可以称为feature 图。然后我们把“男噪声” 和“女噪声”两个相减得到一个差值的feature图, 我们会发现这时候一个非常清晰的图案从噪声里涌现出来,比如我们看到眼角,嘴角,和下巴轮廓等。这就是机器用来分辨人类的特征图,或者说机器识别人脸的因子图。然后团队对人做了相同的分析,也得到人对性别识别的这个因子图, 这时候我们可以分析人和计算机识别人脸的相关性高达0.73 , 说明人和计算机学习到的性格学习方法高度同质化。同时这也说明随机噪声其实是有结构的, 我们对这个特征图做低频和高频的傅里叶分解,可以看到低频部分人和VGG(vgg face)相关性更高。这让机器和人对人脸的表示相关性极高且集中于低频。这里讨论比较认知科学和机器学习的关联的时候,我们最好引入David Marr的三个层次语言体系, 也就是计算层, 表示层,硬件层, 人和VGG模型的计算目标(最高层)是相同的,在硬件层显然大相径庭, 这个研究表明在第二层次表征层两者却是高度相通的。刚刚用到的网络是专门为人脸训练的。我们也可以用迁移学习转移一个从ImageNet训练的通用CNN,然后训练读出层,用迁移学习来识别人脸,这时候两者的表征是否相通呢?实验表明两者表征居然依然是类似的。最后研究团队用sparse coding来认识这件事。sparse coding的原理表明, 随着网络层级的提高,网络表示的稀疏性随层级增加, 这将导致对人脸识别的关键特征会呈现disentagle的离散化形式,也就是可能只有少数神经元编码一个特征(这是神经编码sparse coding和symbolic 表示的内在联系, 最终的表示是一个稀疏因子图) 事实上高层越稀疏, 分类效果越好, 比如alexnet。人脑和深度网络的共同选择。心理学可以用来理解深度学习, 得到一个可解释的神经网络。*** 从这个讲座一个有意思的延申, 似乎我们个人识别美丑的特征正是这些用于性别识别的特征。

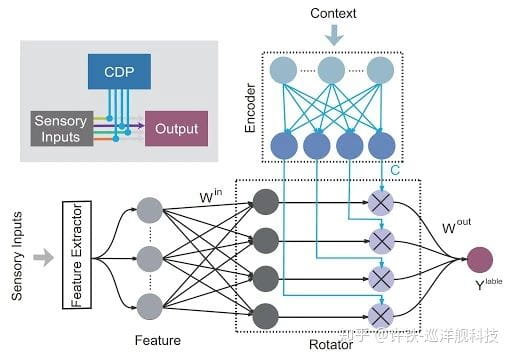

2.3 吴思 The cross talk between biology and computer vision我们所熟知的深度网络泛化能力有限, 容易受到噪声干扰, 其关键问题是不能抓住全局信息。**所谓的全局信息在图像处理的重要体现就是拓扑信息。人对图片的认知从来是从宏观到局部认知的, 所谓top-down-processing。 一个重要的假设是我们对图象的理解是从图象整体的拓扑结构一步步展开的:首先人的认知从拓扑开始的,人的图像理解是一个猜测认证的过程,在一个不确定的图片里, 人要通过物体的整体轮廓对可能的情况进行猜测(sub-cortical pathway 比如天空中飞翔的鹰的影子),然后再提取出和这个整体轮廓相关的细节(ventral pathway,从细节到整体),鹰爪,鹰眼·, 补充对整体的认知,经过一个循环得到对视觉事物的认知 。人,先验的知识, 经验,记忆决定了我们要看到什么。从高级到初级视皮层的。深度学习只模拟了从细节到整体的ventral pathway, 而没有那个事先提炼整体的通路subcortical pathway。实验表明人脑能够非常快速的探测图像的拓扑信息, 这似乎揭示这个拓扑的认知并非那么困难而是存在于比较基础的脑区。事实上这个对图象的宏观拓扑特征提取的机制可能从视网膜就开始了, 人眼里的RGC cell通过电突触gap junction相连(正反馈),使得这部分神经元可以快速的同步化,同时兴奋和抑制神经元间存在旁侧抑制。这种正负反馈并存的一个后果是对图象宏观结构的自然分割,**比如白色背景(天空)中的一个黑色局部(老鹰)。这种同步可以帮助大脑很方便的提取低频信息,如同在原野上燃烧的一把火,它会自然的把易燃的草地和岩石给分隔,从而抓住拓扑特征。我们能否利用人类对视觉图像理解的这种两通路设计来构建一个人工神经网络呢?第一阶段利用subcortical pathway 来实现整体的轮廓提取, 第二阶段再利用ventral pathway的原理做细致的分类。 动力学上看第一个回路的启动速度要快于第二个回路, **在第一阶段通过拓扑提取回路的同步和正反馈来抓住大类。第二阶段, 则通过负反馈来去掉大类平均强化对细节的注意,如此反复循环,这将实现非常具有鲁棒性的对视觉物体的理解!吴思最终在讲座中指出, 当人工智能发展下去到认知,人脑和AI会越来越近。** 这个讲座告诉我们当下的深度学习和人类认知的很大区别在于缺乏人脑的丰富动力学机制, 加入这些机制后一些对机器很困难的事情可能是自然而然的。**2.4 余山 From Brain Network to brain-like computation脑和AI很大差异, 如何从计算原理的层面理解这种本质并利用脑启发改善AI?我们首先看细胞和突触层面,神经细胞信息传递靠突触,上游脉冲, 神经递质不总有效, 有随机性的, 30%会发放当上游信号到达。这样随机的发放如何能够支持非常稳健和鲁棒的智能?事实上这不是单纯是生物限制,而是一种主动进化。因为它可以提高系统的泛化性。类似启发在深度学习的体现就是dropout的技术,dropout可以模拟某些细胞和突触发放的随机性,却可以在几乎任何任务减少泛化误差。另一个重要的生物启发是临界,我们知道生物神经网络的动力学处在稳定和混沌的边缘,所谓一个临界的状态。**从图网络传播的角度,这个时候的网络内部信息具有长程关联,又不至于信息爆炸。**利用这个原理我们可以设计蓄水池网络,这是一种在临界态处理信息的RNN网络因为这个时候的工作效率最高。有意思的是,这个混沌和秩序边缘的状态非常像一个finetune的精细调参结果。大脑不可能调参,它是如何维持临界态的?这时候我们必须拿出自组织临界的重要原理,**通过引入负反馈, 我们可以使得临界态处于一个系统的收敛稳定点状态,从而在非常广的参数范围内,实现临界。**很多人认为批量正则化BN使用了类似的原理让神经网络处于稳定的状态。余山的另一个部分讲座讲解了如何设计能够根据情境调节的神经网络。我们知道人工神经网络不能进行情景化处理(也就是依据不同情境调节自己的认知状态),而这是大脑的本质特点。背后的重要原理是大脑是个平行通路的系统,从sensory cortex进来的信息, 一方面直接通过视皮层层层抽象, 并输入给运动皮层作动作决策(下意识动作),另一方面通过cortex进行认知推理,得到关于情景的高层信息, 再往运动皮层推(理解之上的动作), 类似于我们说的系统一和系统二。我们能否根据这个原理设计一个神经网络?因此我们可以在CNN中加入一个平行于前馈网络context modulation 模块(yu 2019)。这个模块可以调控感知信息的处理过程。**事实上这个模块更加类似一个学习的调控器,它可以根据识别到的情景对在网络内传递的梯度进行调整,从而显著缓解灾难遗忘改善连续学习。**因为学习新内容的过程无疑会擦掉以往权重,这导致神经网络很难持续不断的学习到新的内容,而刚刚加入的情景调控模块引入一个OWM算法, 也叫正交调节器。就是当这个模块识别到情景的变化,就把权重的学习投影到与之前情景正交的子平面上。 Yu Nature Intelligence 2019

Yu Nature Intelligence 2019

** 余山的讲座提到的核心点与吴思有相通之处,就是充分利用人脑的平行回路原理。脑与认知模块总结:如何利用脑启发改善AI的模块是我本次大会最喜欢的模块, 从这里,可以看到大家达成共识的点是 1,大脑是个动力学系统, 很多动力学的基本原理对AI目前的致命缺陷有重大补充, 因果或逻辑可能蕴含在动力学里。临界很重要。 2. 人脑的稀疏表示与符号注意AI和因果有重要联系 3, 充分利用平行回路设计系统3 Consciousness AI

大会也涉及了当下认知科学和AI交叉领域的最hot topic - 意识,虽然只是一小部分、会议邀请了研究意识问题的计算机科学家Manuel Blum 和 Lenore Blum两个专家(夫妇)。首先, 两个科学家介绍了意识作为科学的发展史。1988 年 科学家首次发现了意识的实验证据 (FMRI evidences) , 之后人们从不同领域进入意识的研究, 比如神经科学, 哲学, 计算机。之后Blum指出如果要建立一个意识的模型,它需要具备的特点。首先意识的模型并不等价于全脑模型,但是它必须符合涌现性的原理(复杂科学最重要的概念, 复杂从简单中脱颖而出的一种跳跃变化), 而且构成意识的神经组织和非意识的组织应该是共享的而非隔离的(同样脑区可以既处于有意识也处于无意识状态)。然后Blum指出了如何让意识模型和计算机模型对应。它提出意识的功能是一个从长期记忆力提取短期记忆内容的提取器(类似一个pointer)。因为我们的长期记忆事实上处于无意识状态, 这个内容的数量浩如星海。而短期工作记忆却是你我都可以意识到的, 但它通常只有几个bits。这个信息瓶颈可能就是需要意识来实现,它需要根据当下的任务和情景把和任务最相关的因子提取出来。 这正是著名的(conscious turning machine) Baar’s global workspace model 。这样存在的意识可以迅速的把长期记忆的关键因素抽取到working memory里,方便当下任务的执行,大大加强了系统的灵活性。然后它指出意识可能的具体形态需要包含1, inner voice 2 inner image 3 feeling 4 thought非常有意思的是, 意识在取出很多脑区后依然存在。最后Blum指出意识可能必要的模型组成成分: 1. Inner-dialogue processor

2 model-of-the-world processor

4 图网络专场

4.1 唐建 如何借助图网络构建认知推理模型深度学习需要认知推理已经是人所共知,但是如何实现,图网络是一个重要的中间步骤 。大家可能熟悉当下红红火火的图网络,但是不一定熟悉它的前身条件随机场。唐建老师认为, 这两个模型分别对应人脑中的系统一和系统二认知。所谓的系统一我们可以认为是systemI(graph network) 和system II(conditional random field) 认知模型。基于图的conditional random field模型可以对概率进行计算和推理。为此我们定义一个potential function, 用条件概率乘积形式来表示不同节点间的依赖关系 , 但是这一定义形式往往过于复杂,优化也很困难。这种学习类似于人类较为缓慢的总结关系规律的系统二推理。而图网络则相反,利用message passing的思想, 得到node representation, 这中间我们并没有直接模拟node和node间的统计关系, 但是我们可以通过拟合node上的label来获取node之间的基本关系。因此这样的学习更加类似于人类直觉思考的形式。可否把两者的优势结合呢?这就是最后要介绍的,如何把图网络和条件随机场的优势结合起来做推理。整个框架类似于一个EM算法,我们由一个已知部分节点和边的信息的图网络出发, 在E步骤我们需要由图网络的直觉做inference 推测 , 这样我们会得到大量新的标签, 而在M步骤这些新增加的标签会辅助条件随机场模型更好的算概率, 更新连接图,我们得到一个循环。

如此的方法可以被用于知识图谱推理。我们用马尔科夫logic net 求解所有fact的joint distribution。然后再用图网络学习每个逻辑三元组的权重 有了三元组就可以预测每个事实是对的还是错的。整个思路就是首先可以基于system I (图网络)提供初始预测, 然后用system II基于这些比较初始的预测得到更加具有逻辑的结果,关系推理最终由一个概率图来执行。4.2 何向南 用图神经网络做推荐这其实是一个非常有趣的topic因为推荐系统本质上就是一个图(由用户和商品构成的bi-partite graph)。我们知道早期的推荐系统协同过滤主要是计算相似度。而当下的图网络则本质上用高阶连接性建立协同过滤的信号。通过信息传递得到推荐网络的表示, 在此基础上做推荐 。因此我们需要先定义从一个物品到用户的message,然后通过节点和邻居的连接度矩阵做message passing,得到任意两个节点的相似度,这是我们可以预测某个未知商品和用户关系的基础。在此之上,我们还可以加入用户意图。因为一个人和物品产生交互的时候, 背后的意图是不一样的则推荐的机制不同。如何能够对不同用户的意图下都学习一个表示就成为关键。这里我们可以巧妙的借鉴attention的机制, 学习一个和用户意图相关的权重。最终我们还需要考虑推荐本身是一个行为而非预测,因为推荐的结果会反过来影响用户的行为(反身性), 很大程度阻碍模型发现用户的真正兴趣。现有的方法需要给一个用于修正这种偏差的bias, 比如降低popular 物体的权重 第二个是用对不那么popular物品的 随机曝光,4.3 沈华伟 GNN的局限性图神经网络内核处在停滞不前的状态。我们说深度学习是炼金术,而事实上, **现在开始流行的GNN也是这样一个炼金术, 和深度学习类似。当年大家分析CNN为什么能work , 那么现在我们必须明白为什么GNN也work。大家看到GNN这么强大的表达能力, 做推理, 做认知,做分子式,做物理,其核心都是围绕图 G = (V, E, E, X)做节点分类,边分类和图分类。我们分析机器学习模型的表达能力, 通常是看它可以分开的模式数量。**而GNN的表达能力能否用类似的角度研究呢?首先, 我们可以把问题定义为GNN模型能够分析的网络种类。对于不同的网络, 其主要特征就是网络的拓扑结构。对于GNN其核心部分是Message passing,当经过一次消息传递,看起来无区别的节点就带上其邻居的信息, 当节点和节点的对外连接不同,这个信息就变得不一样,因此在节点分类的角度, **经过一次信息传递,节点已经形成了根据自己邻域拓扑特征形成的聚类。**当然对于比较复杂的图谱,一次传递可能是不够的,经过两次传递后, 关于网络的更深层特征就会进入到每个节点里,从而使得节点的聚类体现更长程的邻域结构。这样的方法对节点的分类很有效但对图整体的分类却没有那么有效。我们可以把所有节点的表示向量合起来作为图的整体表示,经过信息传递一些不同的图结构明显的被分类了, 而得到根据网络相似度表达的metric,而且信息传递的次数越多似乎这个表征能力越强。然而按照这样的思想传递N次后我们是否可以区分任何网络结构呢?答案确实是否定的。我们可以证明对于特定的网络结构传递多少次信息都无法区分其拓扑结构, 因此靠加大图网络深度提高其表示能力是有局限性的。这个方法揭示了单纯靠信息传递得到结果的图网络方法的局限性。所使用的分析方法叫做 WLtest区分,类似于把整个节点传播过程用树展开。最后看子树的分布。一阶WL_tes通常认为是 GNN表达能力的上界这个分析从根本上揭示出GNN的局限性,它似乎只是对图的结构做了一个平滑 。参考文献:Can you design a layer-by-layer network to achieve more powerful expressiveity than existing GNNsHow powerful are grpah neural nets ICLR2019** 这个talk让我想到用GNN做认知推理真的可靠吗?目前来看, 似乎还有差距。看起来它依然只是一个模式识别的工具。感知 = 模式识别 ,而模式识别本身是够不上认知的。4.4 wang min jie 新的图网络工具箱图神经网络本质基于消息传播模式-message passing paradim,这里面关键的是一个消息传递函数,一个累加函数。当我们假定消息传递函数是线性的,累加函数是average pooling, 且这些函数和特定网络局域结构无关, 我们得到GCN。如果你观察这种结构表达方程,你会发现大名鼎鼎的page rank和GCN公式几乎是同质的,都符合这个paradim。这说明我们可以设计一个更加灵活的工具箱,帮助我们设计新的图网络框架。消息传递,累加, 都都可以扩展成为更复杂的工具,甚至lstm。编辑图神经网络,可能用到已有神经网络的模块。新的面向图神经网络系统,需要和现有的深度学习平台结合。这是deep graph library项目动机,它搭建了张量世界和图世界的桥梁。**这个讲座有趣的地方不在于介绍工具箱而是对图网络精辟的总结。5 知识智能专题5.1 孙一舟 如何在深度学习里加入符号知识符号主义AI在当下的精髓在于knowledge graph, 知识图谱里由无数的triplet(head, relation,tail)组成, 作为知识的计算机的主体。**但是单纯知识图谱是无法做认知推理的, 为了完成这样的任务, 我们需要把它和概率图模型连接在一起。**6 强化学习部分

6.1 Statinder singh 如何让强化学习做discoverydiscovery 是强化学习非常重要的发现和探索过程。谈到强化学习的探索,大家可能都很熟悉epsilon-greedy这一类简单的随机搜索策略。而一个大家往往不会注意的地方是奖励函数。奖励函数不仅是一个有关游戏目标的标量,事实上也可以存储更多游戏有关的知识,比如和探索有关的,这部分奖励又称为内部奖励(intrinsic reward),这类似于你并非因为外在的物质奖励而是由于内在求知兴趣去探索发现的过程。

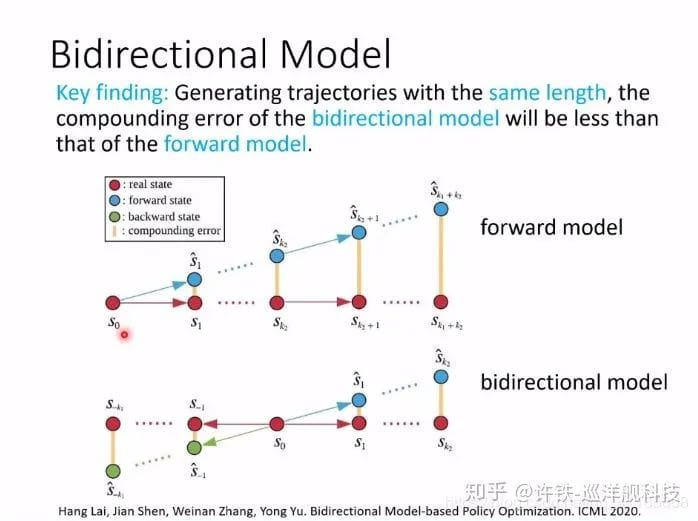

我们发现加入intrinsic reward 不仅可以,能够发现一些不易发现的不变性 ,解决类似于于non-stationary 问题的探索问题。 **此处是否想到因果的counter-factual呢?PPT: blog.csdn.net/qq_411858

**此处是否想到因果的counter-factual呢?PPT: blog.csdn.net/qq_411858

以上是我总结的内容,会议全部内容名单请见:2020.baai.ac.cn/

7 最终总结-世界模型

这次会议是特别有趣的, 不同领域的人根据自己的经验提出了不同的approach在不同角度告诉我们什么可能是达到AGI的最短通路 。那么如果我总结什么可能是一个最短的到达下一个AI阶段的通路呢?其实大会最终采访LSTM之父施密特的对话很有意思。在对施密特的采访中,他兴高采烈的介绍了LSTM的崛起, 和他的贡献,并认为这是一个由大脑启发的能够解决大量不同实际任务的成功典范。那么我们回顾下LSTM为什么如此成功,首先,它是一个动力学模型, 与CNN那些前馈网络不同,LSTM模型事实上可以对一个动力过程进行模拟。而我们的物理学尝试告诉我们,世界的本质就是一台动力学机器,每个齿轮的转动拉动了整个宇宙向前。LSTM具有对宇宙齿轮的模拟能力,因此,它可以做不同的任务,学习不同的领域。这台机器具体包含哪些部分?它有一个记忆memory, 有一个中央动力处理单元h, 是一个神经元互相反馈的通用图灵机, 还有一个执行单元o,输出对未来的预测和动作。这个机器像大脑却不是, 专家最后说施密特未来的神经网络,lstm的接任者需要有什么特征。施密特很快坚定的说它需要更像大脑, 需要具有自我发现和探索的好奇心。然后它需要一个能够预测世界的,尤其是自我行为对世界影响的world model, 以及一个能够根据这些 知识做出行为决策的行为的action model, 这两个model组成一个循环的反馈系统。**这样的模型可以像小孩子一样从真实世界里通过探索学习得到抽象的知识。**我们从这个角度出发,将看到此次大会的所有topic 的联系。这里的第一个关键词是world model,它围绕奖励而来,却时时刻刻满足着自己的好奇心,用来discover真实世界的抽象规律。因果学派说的世界如同一个概率图模型,每个节点之间的关系可以由节点的扰动(do)和它的影响刻画。**说的不正是这个充满好奇的world model需要做的事情,根据自己的行为或自己感测到的外界变化预测未来未知世界的关键?**而具体的这个world model的抽象能力, 不正是类似于在真实的世界中提取这样一个核心变量组成的图网络?因此图网络学派可能说对了世界模型的一个重要组成成分, 它却没有涵盖这个图是怎么产生的这个最核心的议题,如何产生这张图,这让我们想到认知科学启发专题的若干讲座,大脑是如何完成这个工作的。而world model不是关注世界所有的内容,而只关心和智能体完成任务最相关的信息,这就是强化学习的观点, **或者叫做以行为为中心,以任务为导向。**当我们有了world model和action model, 而且world变得越来越复杂不能用一个模型来运转的时候,是不是我们可以在此基础上加一个超级观察者或者叫self model,这个self model可以预测哪些部分的world model 需要进入到action model供action 决策,同时预测action根据这些信息的决策结果?这个self model是不是就是我们要的意识模型呢?由此看, 这几个流派已经贯穿成一体。**最终我们要实现上述的任何步骤,无疑都需要向我们的大脑取经。**因为自然设计已经给了我们一份完美的解决上述通用智能问题的框架,当我们让机器执行的任务和人越来越接近,无疑将会参考这份完美答案。希望更多的人能够对这个问题感兴趣并加入到研究的队伍里(可加微信XUTie0609)。

更多阅读

如何让机器学习关系推测

ICLR认知科学@AI workshop一览

为什么模拟大脑尚如此困难

吸引子2020-06-27 20:36:19

《生命3.0》中对智能的定义是完成复杂目标的能力,如今各领域对于目标的找寻都不相同,对应work的方法也就不一样,如同算法一样,都有自己对应具体场景的适用范围,追根溯源的lstm动力学,回归物理的本源,一滴油墨在水中的扩散,也有它的目标,智能,是我们对认识世界的重构,复杂的目标,是人类负熵体自我成长的驱动力。

梦阳2020-06-27 15:08:43

它会不会也是像我们一样,有一个整体目标,然后分割成许多小目标,并且能够明确各个小目标ABC的正常处理顺序和情况改变时候的处理顺序。

施飞2020-06-27 23:41:56

发现几千年过去了,又回到了原点

1 因果角度

1 因果角度 2 认知和脑网络角度

2 认知和脑网络角度 事实上我们发现salientcy map 从V1 就有很强的表达 ,说明这种自下而上的注意力是很基础的。而这类attention model 也不同于我们AI的模型,而是一个动态图, 始终在搜索图片最具有信息的地方作为关注点, 然后跳到下一个点。构建一个动态的attnetion model 。2.2 刘嘉 From representation to computation : the cognitve neurointelligence通过AI研究大脑, 通过大脑启发AI, 这个讲座告诉大家如何比较深度神经网络和大脑的”思考“方式, 如果有一天两者开始对话,他们能够互相理解对方吗?刘教授从心理学的角度来讲解如何对比深度神经网络和人脑两个信息处理的黑箱到底能否直接进行对比, 假定我们了解了人脑认知的结构, 那么是否可以用来启发人工智能系统 。我们说当下的深度网络是一个黑箱,事实上心理学也经常把我们的大脑比喻成黑箱。黑箱和黑箱进行比较,似乎是不可能的任务, 然而刘嘉团队的方法 -逆向相关化使这个问题变成可能。这里介绍人脸识别(此处以性别识别为例)的工作,无论对人还是计算机这都是一个很重要的工作。然而我们并不清楚无论是人还是机器是怎么完成这个任务的。这里我们可以想法得到女性和男性的平均脸(无数面孔的平均)。然后在这个平均脸上加上各类人为生成的奇怪噪声然后并让机器(一个训练好的VGG网络)分类是男是女, 这样我们就可以得到一组“男性”噪声 和 “女性” 噪声,我们分别把两组噪声再此分别叠加平均后就得到两个奇怪的斑图,我们可以称为feature 图。然后我们把“男噪声” 和“女噪声”两个相减得到一个差值的feature图, 我们会发现这时候一个非常清晰的图案从噪声里涌现出来,比如我们看到眼角,嘴角,和下巴轮廓等。这就是机器用来分辨人类的特征图,或者说机器识别人脸的因子图。然后团队对人做了相同的分析,也得到人对性别识别的这个因子图, 这时候我们可以分析人和计算机识别人脸的相关性高达0.73 , 说明人和计算机学习到的性格学习方法高度同质化。同时这也说明随机噪声其实是有结构的, 我们对这个特征图做低频和高频的傅里叶分解,可以看到低频部分人和VGG(vgg face)相关性更高。这让机器和人对人脸的表示相关性极高且集中于低频。这里讨论比较认知科学和机器学习的关联的时候,我们最好引入David Marr的三个层次语言体系, 也就是计算层, 表示层,硬件层, 人和VGG模型的计算目标(最高层)是相同的,在硬件层显然大相径庭, 这个研究表明在第二层次表征层两者却是高度相通的。刚刚用到的网络是专门为人脸训练的。我们也可以用迁移学习转移一个从ImageNet训练的通用CNN,然后训练读出层,用迁移学习来识别人脸,这时候两者的表征是否相通呢?实验表明两者表征居然依然是类似的。最后研究团队用sparse coding来认识这件事。sparse coding的原理表明, 随着网络层级的提高,网络表示的稀疏性随层级增加, 这将导致对人脸识别的关键特征会呈现disentagle的离散化形式,也就是可能只有少数神经元编码一个特征(这是神经编码sparse coding和symbolic 表示的内在联系, 最终的表示是一个稀疏因子图) 事实上高层越稀疏, 分类效果越好, 比如alexnet。人脑和深度网络的共同选择。心理学可以用来理解深度学习, 得到一个可解释的神经网络。*** 从这个讲座一个有意思的延申, 似乎我们个人识别美丑的特征正是这些用于性别识别的特征。

事实上我们发现salientcy map 从V1 就有很强的表达 ,说明这种自下而上的注意力是很基础的。而这类attention model 也不同于我们AI的模型,而是一个动态图, 始终在搜索图片最具有信息的地方作为关注点, 然后跳到下一个点。构建一个动态的attnetion model 。2.2 刘嘉 From representation to computation : the cognitve neurointelligence通过AI研究大脑, 通过大脑启发AI, 这个讲座告诉大家如何比较深度神经网络和大脑的”思考“方式, 如果有一天两者开始对话,他们能够互相理解对方吗?刘教授从心理学的角度来讲解如何对比深度神经网络和人脑两个信息处理的黑箱到底能否直接进行对比, 假定我们了解了人脑认知的结构, 那么是否可以用来启发人工智能系统 。我们说当下的深度网络是一个黑箱,事实上心理学也经常把我们的大脑比喻成黑箱。黑箱和黑箱进行比较,似乎是不可能的任务, 然而刘嘉团队的方法 -逆向相关化使这个问题变成可能。这里介绍人脸识别(此处以性别识别为例)的工作,无论对人还是计算机这都是一个很重要的工作。然而我们并不清楚无论是人还是机器是怎么完成这个任务的。这里我们可以想法得到女性和男性的平均脸(无数面孔的平均)。然后在这个平均脸上加上各类人为生成的奇怪噪声然后并让机器(一个训练好的VGG网络)分类是男是女, 这样我们就可以得到一组“男性”噪声 和 “女性” 噪声,我们分别把两组噪声再此分别叠加平均后就得到两个奇怪的斑图,我们可以称为feature 图。然后我们把“男噪声” 和“女噪声”两个相减得到一个差值的feature图, 我们会发现这时候一个非常清晰的图案从噪声里涌现出来,比如我们看到眼角,嘴角,和下巴轮廓等。这就是机器用来分辨人类的特征图,或者说机器识别人脸的因子图。然后团队对人做了相同的分析,也得到人对性别识别的这个因子图, 这时候我们可以分析人和计算机识别人脸的相关性高达0.73 , 说明人和计算机学习到的性格学习方法高度同质化。同时这也说明随机噪声其实是有结构的, 我们对这个特征图做低频和高频的傅里叶分解,可以看到低频部分人和VGG(vgg face)相关性更高。这让机器和人对人脸的表示相关性极高且集中于低频。这里讨论比较认知科学和机器学习的关联的时候,我们最好引入David Marr的三个层次语言体系, 也就是计算层, 表示层,硬件层, 人和VGG模型的计算目标(最高层)是相同的,在硬件层显然大相径庭, 这个研究表明在第二层次表征层两者却是高度相通的。刚刚用到的网络是专门为人脸训练的。我们也可以用迁移学习转移一个从ImageNet训练的通用CNN,然后训练读出层,用迁移学习来识别人脸,这时候两者的表征是否相通呢?实验表明两者表征居然依然是类似的。最后研究团队用sparse coding来认识这件事。sparse coding的原理表明, 随着网络层级的提高,网络表示的稀疏性随层级增加, 这将导致对人脸识别的关键特征会呈现disentagle的离散化形式,也就是可能只有少数神经元编码一个特征(这是神经编码sparse coding和symbolic 表示的内在联系, 最终的表示是一个稀疏因子图) 事实上高层越稀疏, 分类效果越好, 比如alexnet。人脑和深度网络的共同选择。心理学可以用来理解深度学习, 得到一个可解释的神经网络。*** 从这个讲座一个有意思的延申, 似乎我们个人识别美丑的特征正是这些用于性别识别的特征。 Yu Nature Intelligence 2019

Yu Nature Intelligence 2019 **此处是否想到因果的counter-factual呢?PPT: blog.csdn.net/qq_411858

**此处是否想到因果的counter-factual呢?PPT: blog.csdn.net/qq_411858